🚨🦾 OPTIMUS 解锁时刻:Tesla 的“时间机器”专利,正在重塑具身智能的底层引擎

工程里最糟糕的感觉是什么?

不是模型不准,而是——

你花了几周训练一个庞大的神经网络,烧掉大量算力;

真正部署时才发现:功耗爆表、温度失控、反应慢了几毫秒。

在机器人世界里,这不是体验问题。

这是“会不会摔倒”的问题。

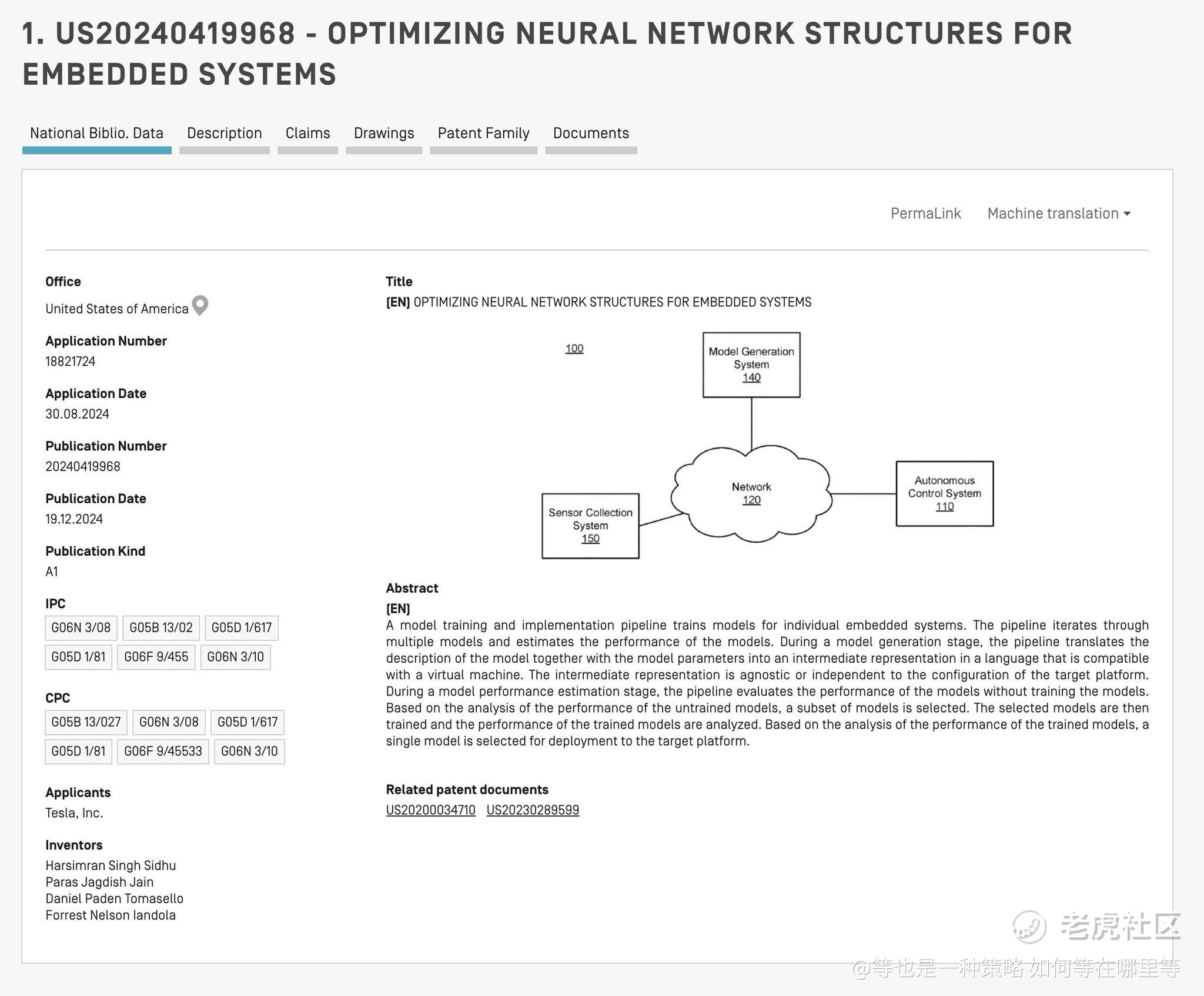

2024 年 12 月 19 日,Tesla 公布了一份专利(US 2024/0419968 A1)。

它读起来不像常规文件,更像是一套“提前看见未来”的工程方法论。

这份专利,正是 Optimus 能成立的关键。

真正的瓶颈,不在算法,而在物理世界。

自动驾驶汽车有大电池和液冷系统。

人形机器人没有。

Optimus 使用的是体积受限的小型电池,封闭躯干,热量难以散出。

任何低效的内存访问都会变成热。

任何热量上升都会迫使系统消耗本该用于行走、抓取和平衡的能量。

更残酷的是实时性要求。

Optimus 需要同时融合高分辨率视觉、手部触觉,以及 40+ 执行器的位置反馈。

在车上可以忽略的延迟,在双足机器人身上就是灾难。

“之后再优化”这条路,在具身智能里根本走不通。

Tesla 的解法,是把“大脑”和“身体”彻底解耦。

神经网络不会直接绑定某一块芯片,而是先被翻译成一种中间表示——

只描述数学结构,不关心运行环境。

真正运行时,由设备上的专用 Virtual Machine 来实时解释和调度。

它的目标不是抽象优雅,而是工程残酷。

在模型还没开始训练之前,系统就能数学级别验证:

这个结构能否满足亚毫秒级反应?

是否超出内存带宽?

是否会突破热与功耗边界?

失败的方案,被几分钟内淘汰,而不是几个月后才发现。

这是真正意义上的 fail fast。

专利里有一个非常关键的“现实校验”。

每个模型都会被计算两套指标:

Naive 指标,代表理论上想做的计算;

Optimized 指标,代表编译后在真实硬件上的结果。

如果两者差距过大,或优化后依然触碰硬件天花板,系统不会只给一个“错误”。

它会直接指向可执行的修改方向:

减少层复杂度、重排张量结构、调整调度策略。

在任何算力被浪费之前,就把方向拉回现实。

一旦结构通过验证,编译器开始“压榨效率”。

神经网络被拆成计算图,能合并的操作全部融合。

乘法和加法,被压缩成一次指令。

结果不变,计算周期却明显减少。

机器人“思考”得更快,但处理器并没有升级。

真正被当作头号敌人的,是内存。

Tensor Scheduler 精确追踪每一块数据的生命周期。

临时变量用完即回收,立即复用。

内存占用被压缩到极限。

如果计算规模依然过大,系统会主动改写数学过程:

把一次巨大的运算拆成适合缓存的小块。

哪怕多做一点重复计算,也要减少数据搬运。

在机器人系统里,算力便宜,带宽昂贵。

运行时同样不是静态的。

Virtual Machine 会根据设备当前的硬件状态,生成全新的执行树。

一旦 OTA 带来更高效的计算内核,系统会自动切换执行路径。

模型架构无需修改,效率却持续进化。

这解决了几个长期难题。

同一套核心智能,可以在汽车与机器人之间复用。

老硬件不会被快速淘汰,通过更聪明的调度继续跑更大的模型。

工程团队可以为“尚未出现的下一代芯片”提前写软件,在硅片诞生前就完成验证。

这不是单一功能的突破。

而是把具身智能的隐形天花板整体抬高。

更低热量。

更低延迟。

更长续航。

更快迭代。

Optimus 从展示走向部署,靠的正是这种底层工程。

市场真正需要思考的,也许不是“机器人什么时候量产”,

而是——这种基础设施的复利,是否已经被充分计价?

📬我会持续解析科技公司在系统架构层面的关键拐点,关注那些真正改变长期能力曲线的工程选择。

如果你也在研究 $TSLA 的长期演进,这类细节往往比发布会更重要。

你觉得具身智能的最大瓶颈,会先被模型突破,还是被这种系统级工程彻底解决?

#Tesla #Optimus #EmbodiedAI #Robotics #ArtificialIntelligence #AutonomousSystems #AIInfrastructure

精彩评论