在 CES 2026 的官方开幕主题演讲舞台上,AMD 对未来五到十年计算版图进行了梳理。

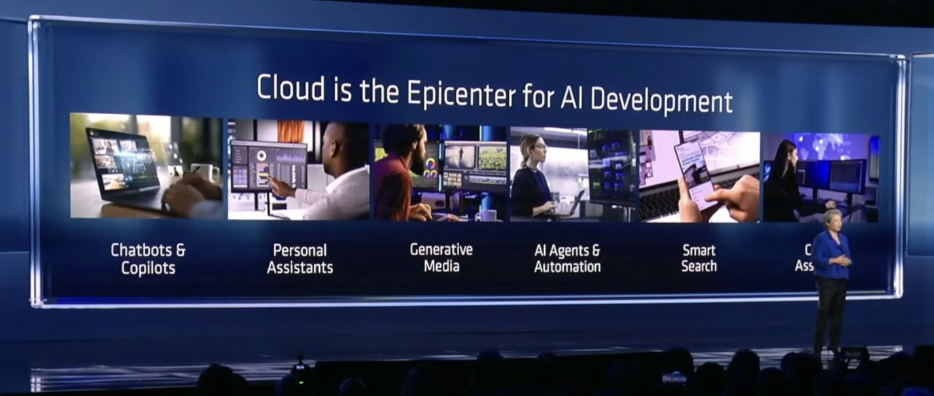

AI 已经从概念热潮走向基础设施竞争;无论是数据中心、终端 PC,还是机器人、医疗、科学计算,几乎所有前沿应用都在同时拉高对算力的需求。

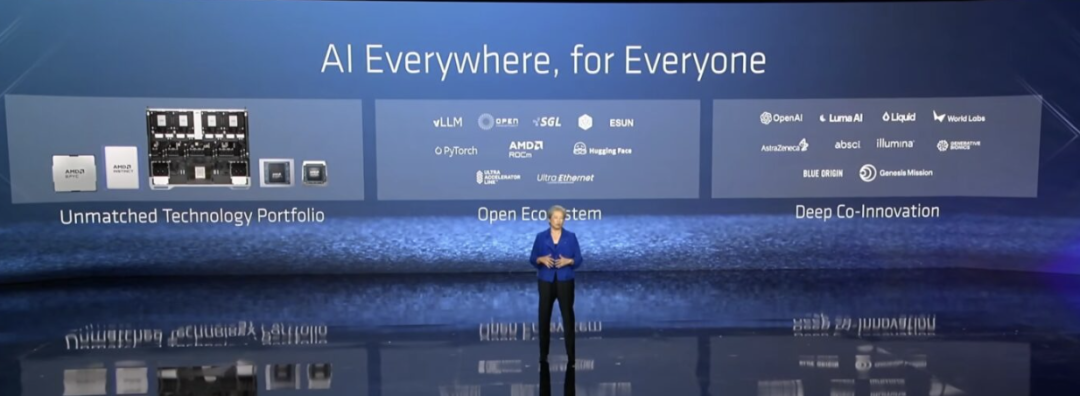

AMD 在 CES 2026 上讲了一条工程与系统的路线:如果 AI 用户规模真的在五年内走向 50 亿级别,那么真正的瓶颈不再是某一代 GPU 的峰值性能,而是整个计算体系能否在云、边缘、终端之间形成可扩展、可负担、可持续的闭环。

演讲一开始,苏姿丰就说:“10 YottaFLOPS”不是单纯的性能口号,而是一个前提——AI 的普及意味着全球计算能力需要出现数量级跃迁,而这不可能只靠单一形态的硬件完成。

数据中心

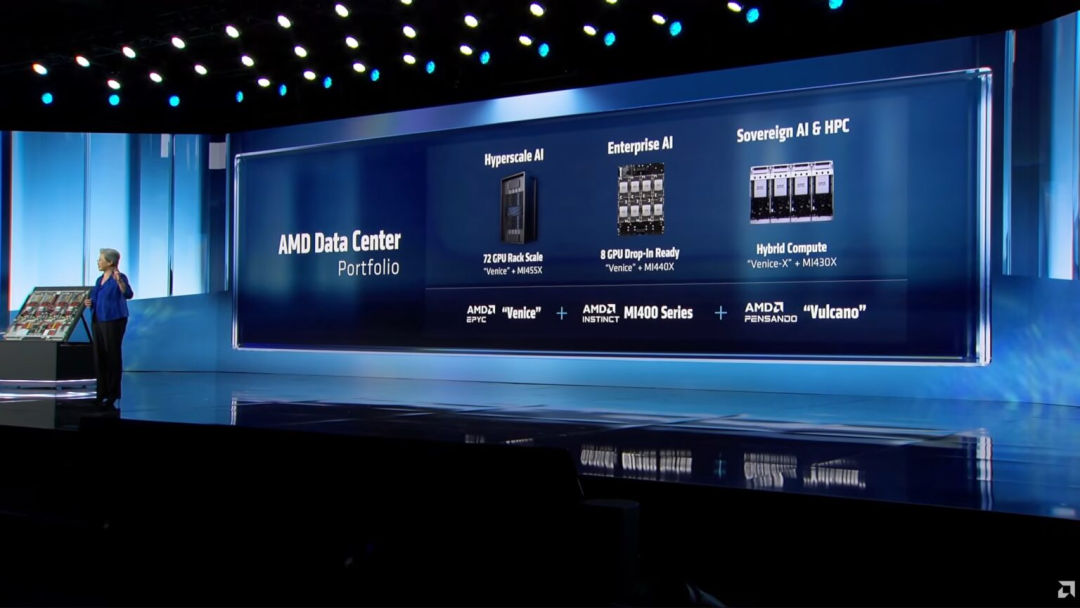

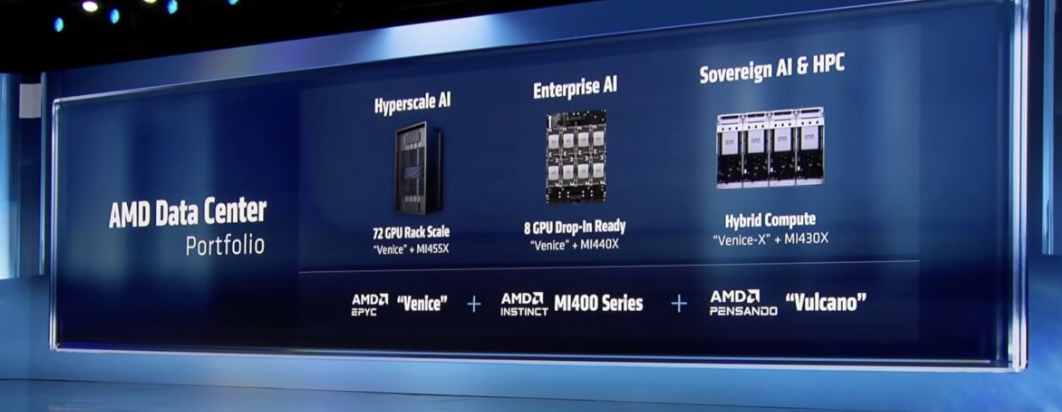

正是在这一背景下,AMD 重点讲了对数据中心的布局。

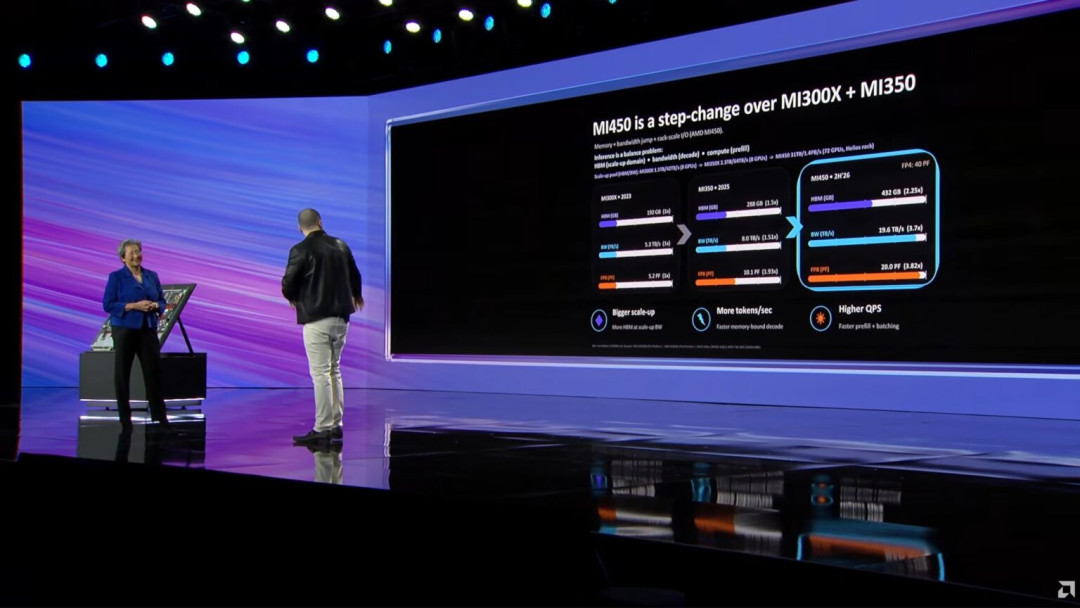

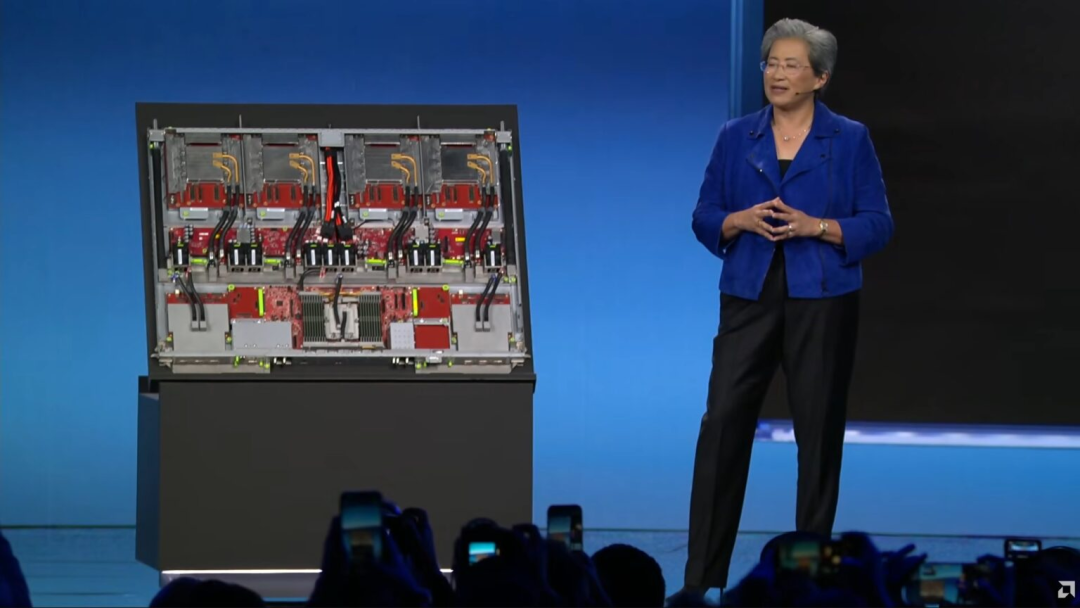

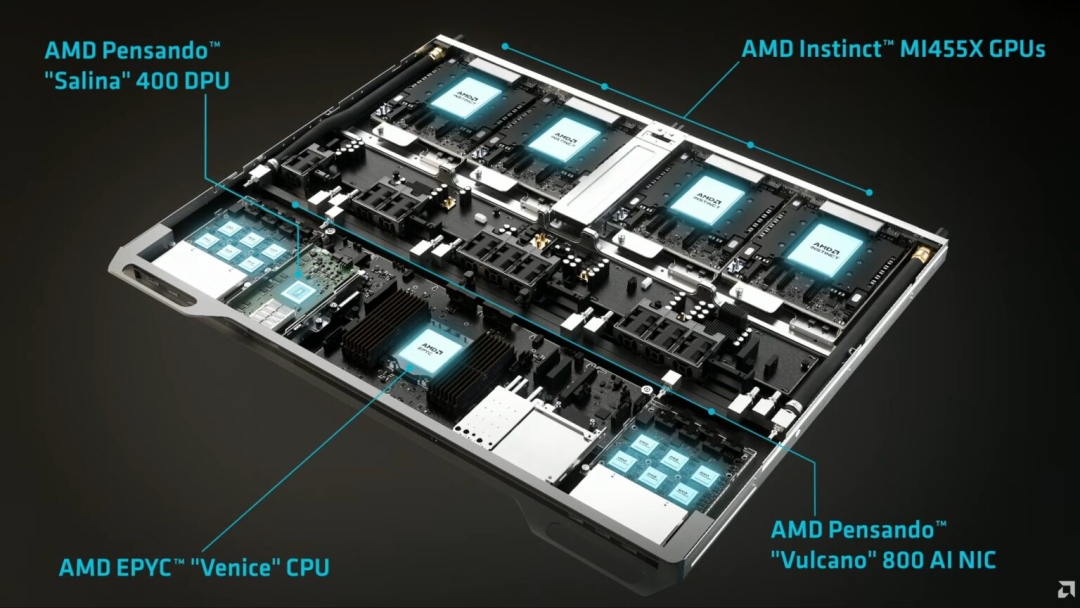

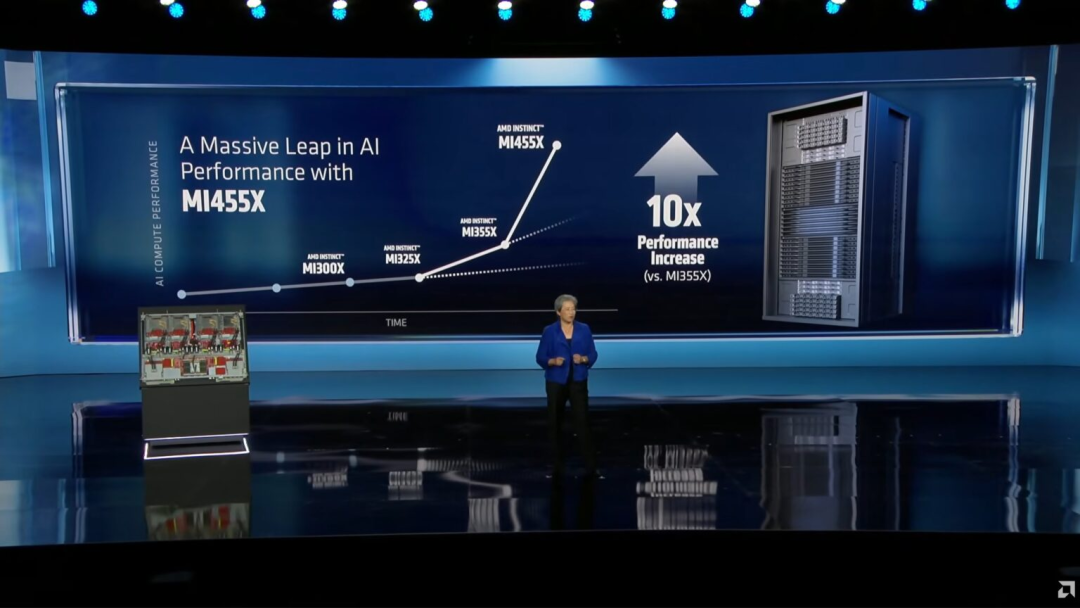

Helios 机架式平台与 Instinct MI400 系列的亮相,是 AMD 对“Yotta Scale AI”这一概念的首次工程化呈现。

单机架 72 颗 GPU、超过 31TB 的 HBM4 内存、43TB/s 的横向扩展带宽,AMD 正试图用标准化机架形态,把原本高度定制化的超算级能力,推向云厂商和大型 AI 客户可以规模部署的形态。

Helios 是 AMD 试图进入 AI 训练主战场的关键载体。

智能体工作流、长时间运行的推理任务,还是医疗、教育等高价值场景,对计算资源的需求正在从“更快”转向“更久、更稳、更可扩展”。

从 MI300 到 MI450 再到 MI400,AMD 强调单点性能超越,强调 TCO、部署密度和可持续扩展,这实际上是在正面回应当前 AI 基础设施的真实痛点:算力是能不能长期用得起、用得稳。

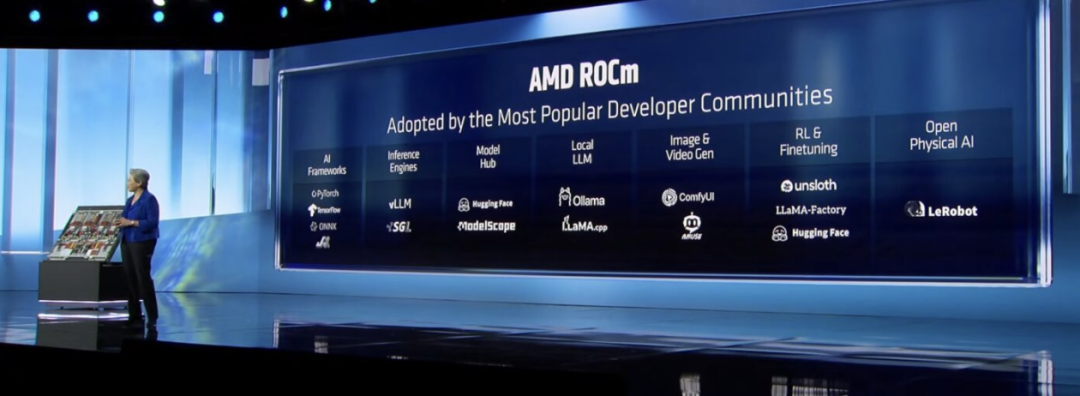

ROCm 也在演讲中被反复提及,这是为AMD 区别于竞争对手的“开放性”核心。

Luma AI 60% 的推理负载运行在 AMD GPU 上,还是 Liquid AI 将本地模型直接跑在 Ryzen AI 平台上,AMD 希望通过硬件覆盖面和软件适配能力,成为 AI 工作负载的“通用底座”,从长期看是一条更偏产业基础设施的路径。

AI PC

切换到 AI PC,AMD 延续了类似的思路:

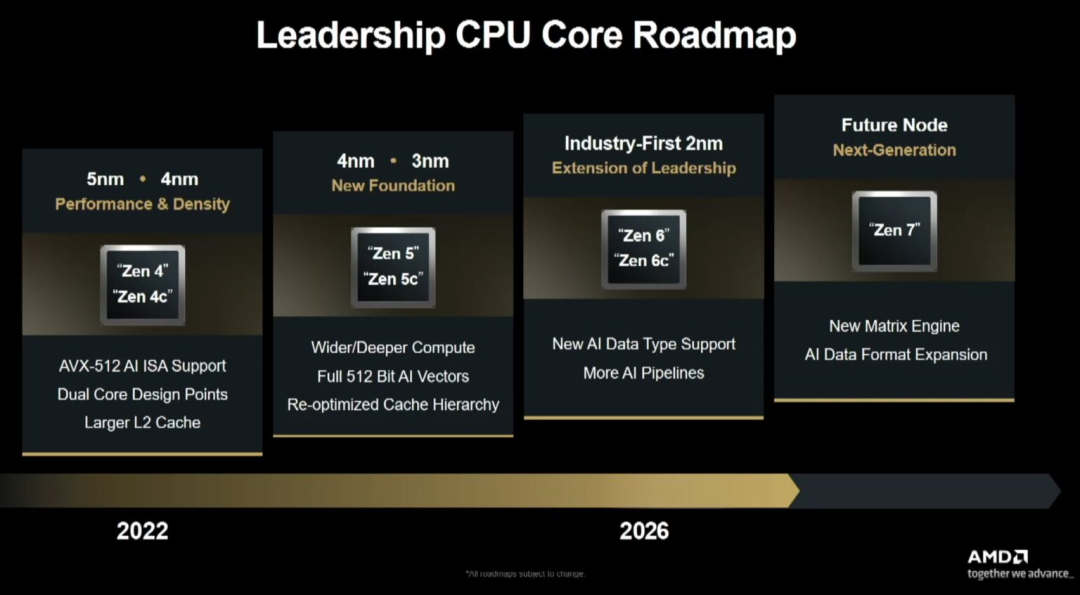

Ryzen AI 400 系列并非架构代际的大跨越,而是在 Zen 5 生命周期中期,对 NPU、CPU 与 GPU 协同能力的系统性强化。

无论是 Liquid AI 的本地模型,还是 Ryzen AI Max 所吸引的开发者群体,是“哪些工作负载应该从云端下沉”,未来 AI 的成本结构,将迫使一部分推理和交互回到终端完成,而 AMD 希望提前占据这一节点。

Ryzen AI Halo 的发布则进一步明确了这一定位。

作为面向本地 AI 开发的参考平台,是 AMD 给开发者的一套“低门槛算力工具箱”,与 NVIDIA DGX Spark 形成直接对位。

这并不是消费级产品,而是生态级产品,目的是让更多 AI 应用在 AMD 平台上原生诞生,而不是事后迁移。

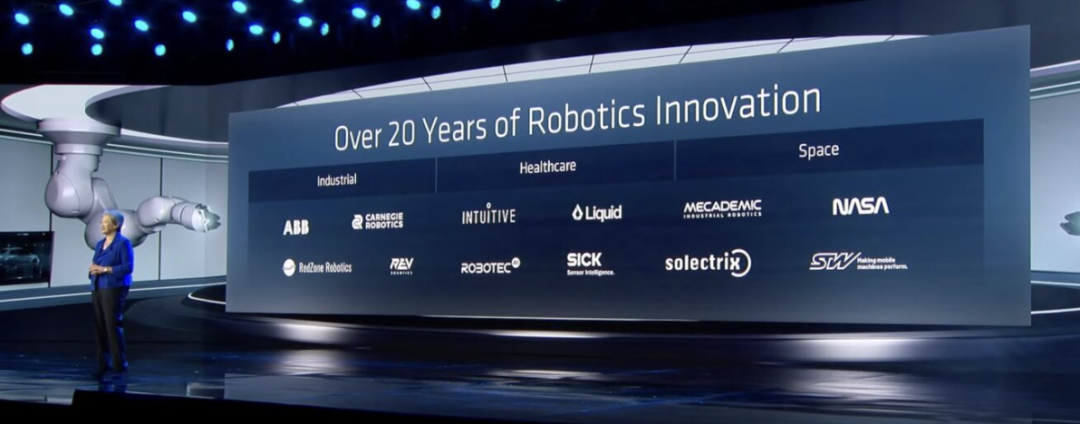

演讲后半段大量篇幅讲了医疗、机器人、太空和科学计算, AMD 对“物理 AI”与“关键任务计算”的刻意强化。

从 Generative Bionics 的仿生机器人,到 Blue Origin 的耐辐射嵌入式系统,真正高价值的 AI 应用是在现实世界中,而这些场景对计算的要求,远比互联网服务更严苛。

苏姿丰在结尾反复强调“AI is different”,AI 不只是提升效率的工具,而是一个正在重塑科研、医疗、制造和探索方式的基础变量。

相比强调某一代 GPU 的领先优势,当算力成为社会基础设施时,自己是否已经铺好了足够宽的底座。

小结

2026 将是 AMD披露其战略轮廓真正成型的一年,用一整套从云到端、从软件到系统、从商业应用到国家级项目的拼图,去证明自己在 AI 时代的长期位置。

精彩评论