黄仁勋被逼急了,英伟达超级芯片提前发布

“AI已经进入工业化阶段。”这是黄仁勋近日在CES 2026演讲中的核心断言。

他带来的,是即将量产的Rubin平台——这个以天文学家维拉·鲁宾命名的系统,代表着英伟达对下一代AI计算的重新定义。

图源:微博

黄仁勋坦率表示,AI模型规模每年增长10倍,推理所需令牌数量每年增加5倍,传统的芯片设计方法已无法跟上AI的发展速度,这迫使英伟达重新设计每一款芯片。

面对来自AMD、博通和谷歌自研ASIC的多维竞争,老黄终于使出了一套完整的平台级战略。

Rubin提前量产,令人震撼

一句话评价:此次英伟达发布的Rubin平台不是一次简单的硬件升级,而是一次彻底的架构革命。

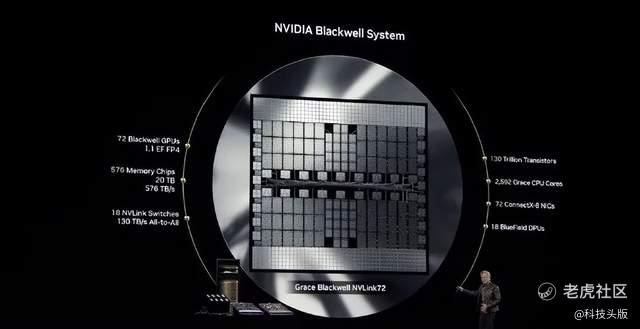

它由6颗专门设计的芯片组成:Vera CPU、Rubin GPU、NVLink 6 Switch、ConnectX-9智能网卡、BlueField-4 DPU和Spectrum-X 102.4T CPO。

其中,Vera CPU作为英伟达新一代计算架构的核心,采用了88个物理核心的设计,通过空间多线程技术实现176线程满速运行,与传统的CPU设计思路截然不同,它更加强调在功耗受限环境下的性能密度,而非单纯的核心数量堆叠。

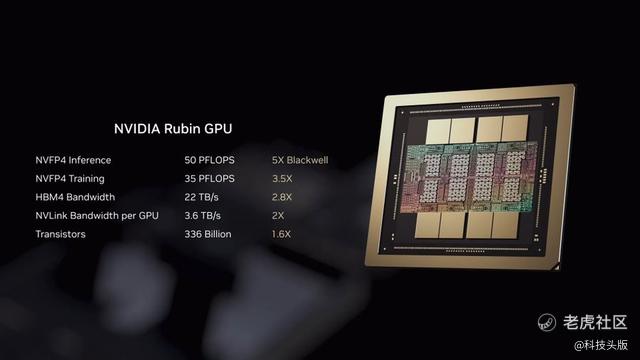

与此同时,Rubin GPU的表现也令人印象深刻。虽然晶体管数量仅为上一代Blackwell的1.6倍,但在浮点性能上却实现了超越。这一突破来自于全新的张量核心与Transformer Engine设计,而非简单的规模扩大。

图源:微博

事实上,Rubin平台代表了英伟达对“极致协同设计”理念的彻底贯彻。与以往各组件孤立优化的做法不同,英伟达将GPU、CPU、网络、安全、软件、供电和冷却系统作为一个单一系统进行整体设计(对应以上芯片介绍)。

黄仁勋在演讲中透露,这个系统的复杂性超乎想象,一个装满冷却液的AI机柜重达2.5吨,但组装时间却从2小时缩短到仅5分钟。

该设计理念源于AI工作负载的根本性变化。现代AI系统已从处理离散任务,演变为持续运转的“AI工厂”,需要全天候、不间断地将电力、硅和数据转化为智能。

性能方面,Rubin平台与前代Blackwell相比,在推理性能上提升了约5倍,训练性能提升了约3.5倍。

更重要的是,在处理混合专家模型时,训练所需的GPU数量减少到了Blackwell平台的四分之一,推理令牌生成成本则最多可降低10倍。

更夸张的是,据老黄介绍,Rubin平台的成熟度已达到量产水平,所有芯片已进入合作制造和测试阶段。主流云服务提供商如AWS、谷歌云、微软Azure、Oracle等均已确认将在2026年推出基于Rubin平台的计算实例。

图源:微博

据悉,早在2024年英伟达就已对外公布了Rubin架构的存在。而在2025年10月的华盛顿GTC大会上,黄仁勋第一次对外展示了Rubin芯片的样片,并透露其算力指标能达到当时主力出货产品Blackwell系列芯片的3倍以上。

彼时,业内人士普遍猜测英伟达将在2026年下半年正式发布并量产Rubin。

但在本次CES上,黄仁勋宣布Rubin架构目前已经实现全面投产,时间节点大幅提前。

OpenAI首席执行官Sam Altman评论称:“智能随算力而扩展。当我们增加算力时,模型会变得更强大,能够解决更棘手的问题,并对人类产生更大影响。NVIDIA Rubin平台帮助我们持续这一进程。”

此外还有马斯克等诸多大佬对此发表了自己的看法,全部被收录进NVIDIA(英伟达)官网:

图源:NVIDIA官网

AI正从理解语言迈向理解物理世界

黄仁勋在CES上提出了一个标志性观点:“物理AI的ChatGPT时刻已经到来。”

他想表达的意思是,AI正从理解数字信息,走向理解并与物理世界互动。该现象被黄仁勋称为“物理AI”(Physical AI)。

自动驾驶是这一战略的先导应用。英伟达推出了Alpamayo系列开源AI模型,这是业界首个具备思维链推理能力的视觉语言行动模型。

它能逐步分析罕见或全新驾驶场景,提升车辆的可解释性和安全性,由NVIDIA Halos安全系统提供支持。

Alpamayo的价值在于应对自动驾驶的“长尾难题”。传统的分离式感知与规划架构在遇到新情况时扩展性受限,而Alpamayo的端到端学习框架通过逐步推理因果逻辑,即使面对训练数据之外的情况也能安全决策。

首款搭载该系统的梅赛德斯-奔驰CLA将于2026年第一季度正式上路。

图源:观察者网

与此同时,英伟达正以前所未有的开放姿态构建机器人生态系统。

在CES上,波士顿动力、卡特彼勒、Franka Robotics、LG电子等全球行业领导者展示了基于英伟达技术栈的新一代AI驱动机器人。

黄仁勋兴奋地宣布,英伟达正通过开放模型降低机器人开发门槛。

NVIDIA Isaac GR00T N1.6是专门为人形机器人设计的开源模型,能够实现全身控制,并利用NVIDIA Cosmos Reason模型获得更好的推理和情境理解能力。

如此推崇开放策略的背后,是英伟达将超过200万机器人开发者与Hugging Face的1300万AI开发者社区连接起来的宏大愿景。

机器人已成为Hugging Face上增长最快的类别,而英伟达的开放模型和数据集下载量领先。

图源:微博

黄仁勋的野心不止芯片

在整场演讲中,黄仁勋反复强调英伟达的定位:不做AI应用的竞争者,而是成为整个AI产业的“卖铲人”。

他对此解释道,计算产业每隔10到15年就会发生一次底层重置:从大型机到PC,从互联网到云计算,再到移动计算。

这一次,两个平台迁移同时发生:一是应用本身从“编程”转向“训练”,二是整个计算栈被重写,CPU不再是中心,GPU成为默认。

黄仁勋估算了这场重置的市场规模:全球传统计算体系规模约为10万亿美元,而这部分基础设施,正在被系统性地“现代化”为AI计算。

这种现代化进程并非由增量投资驱动,而是来自企业研发预算、风险投资和整个工业体系的迁移。

英伟达在这一市场中的战略选择非常明确:作为“卖铲人”,为所有人提供新平台的基础设施。

图源:微博

开源策略成为英伟达生态扩张的关键抓手。黄仁勋在演讲中特别赞扬了开源模型的革命性作用,并再次强调了来自中国的DeepSeek模型带来的影响。

他表示:“开源模型的崛起成为全球创新的催化剂,其中Deepseek R1的出现意外推动了整个行业的变革。”虽然顶尖开源模型与最前沿专有模型之间仍有约6个月的差距,但这种快速迭代正激活全球创新。

黄仁勋强调:“我们怎么可能让智能的数字形式抛下任何人?”

英伟达自身也投入了价值数十亿美元的DGX超级计算机集群来推动开源模型发展,并在蛋白质结构预测(Open Fold Three)、天气预测(Forecast Net)等多个科学领域取得突破。

更关键的是,英伟达的生态系统已经延伸到硬件供应的最上游。黄仁勋特别提到,台积电是Vera Rubin幕后的关键推手之一。

双方在制程、封装到光电整合展开深度协同设计,并以其COUPE技术,将硅光子直接整合至交换晶片。

此外,英伟达还与英特尔合作,将NVLink的应用场景拓展至x86 CPU,进一步扩大在服务器互连领域的影响力。

英伟达还推出了专门针对大型语言模型推理应用的Rubin CPX架构,引入了全新的机柜概念,并在芯片间采用PCIe 6互连。

从芯片性能的单一竞赛,到AI工厂的系统级优化;从封闭的硬件生态,到开放的机器人开发平台;从单打独斗的硬件巨头,到连接全球开发者的生态核心。

黄仁勋的皮衣之下,包裹的是一个正在从硬件公司蜕变为AI时代核心基础设施提供商的科技帝国。

作者 | 刘峰

免责声明:上述内容仅代表发帖人个人观点,不构成本平台的任何投资建议。