任少卿的智驾非共识:世界模型、长时序智能体与“变态”工程主义

留在智能驾驶,不是因为容易,而是因为更难。

文丨魏冰 宋玮

编辑丨宋玮

任少卿的头发很有辨识度,浓密、微卷,刘海盖住额头。走进会议室,第一次见他的人把他当成了实习生,知道身份后调侃说,只有在 AI 创业公司才能看到这么年轻的技术 leader。

“我们就是 AI 公司”——任少卿一本正经的回答。

但他身处的是蔚来,一家还在血海中搏杀的汽车制造商,而他的战场,是智能驾驶。这个反常回答,和他的人生轨迹相似:总在别人以为答案已定的时候,他偏要走向另一个方向。

2007 年他考入中科大,2016 年博士毕业。期间他提出了 Faster R-CNN(一种基于深度学习的目标检测框架),又和当时微软亚研院视觉计算组的孙剑、何恺明,博士生张祥雨一起研究 ResNet(残差网络)。后者解决了神经网络越深越 “失忆” 的难题,让模型可以无限叠加层数,被视为深度学习史上的里程碑。当时任少卿 27 岁。

2016 年,他与曹旭东共同创立自动驾驶公司 Momenta,亲历了自动驾驶最热的创业年代。4 年后,他离开一手创立的公司,转身去了还在低谷挣扎的蔚来。

原因很简单,当年 AI 发展撞上瓶颈,他认为下一次突破只能靠大规模数据叠加,车企是当时唯一能提供大规模摄像头数据的场景。事实也验证了这个判断——2022、2023 年大模型的进步,本质来自数据与算力的叠加。

在蔚来,他一个人接手了几乎从零起步的二代平台,芯片、传感器没定,软件和工程都未开启,却要在 20 个月内实现量产。最后,他完成任务,并推动建立了三层套数据体系,为蔚来智驾打下底层能力的地基。

从那以后,任少卿走的每一步都显得 “不合时宜”。

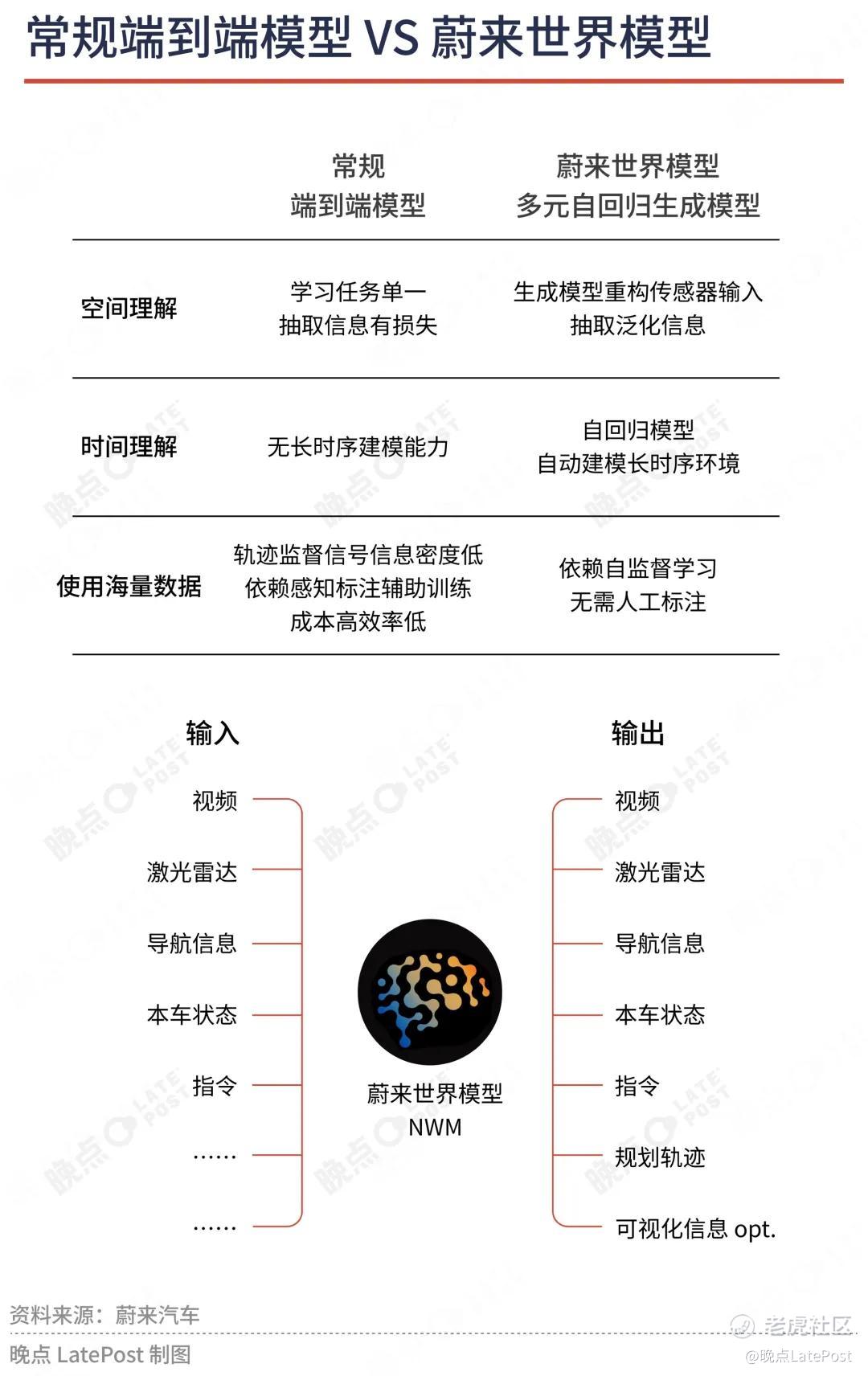

他将车企比拼的端到端理解为 “填坑”,依赖的是模仿学习,能解决一些短时序问题,但能力止步于几秒钟的反应,无法扩展到长时序的推理与决策。后来的 VLA(Vision-Language-Action)模型看似往上走了一步,把语言与动作绑在一起,但依然以语言为中心。语言带宽有限,无法承载现实世界的连续复杂性。

任少卿认为真正的上限在世界模型,即以视频为核心,通过跨模态的互相预测和重建,让系统学习时空和物理规律,再叠加语言层去交互与注入知识,让机器能像人一样理解环境。

他选的难路不止一条。另一条是强化学习,任少卿说,智驾行业至今没有真正接受 RL (Reinforcement Learning ,强化学习)的重要性。模仿学习像老师手把手教你五秒,当场景拉长到三十秒、六十秒,就会失效。必须靠强化学习,把短时记忆的 “金鱼”,进化为能处理长时序的智能体。

可以说,蔚来选了一套最难组合:高算力、多传感器、全新架构(世界模型加强化学习)。

“没有哪家公司像我们这样变态。” 他说。这意味着更重的训练、更长的周期,但换来的是一套真正接近物理世界的能力栈。

在强调速度的汽车行业,坚持这样的路径,本身就是一种冒险。

“我们做很多事情,不是为了跟别人赛跑,而是希望能探索一些新的东西。我们做得更多,因为我认为这是一条真正可以通向未来的路,即便过程中我们要忍受一段时间的不被理解。”

很多 AI 创业者喜欢用攀登雪山或大航海来比喻探索之路。但任少卿不这么形容,他觉得博士时的状态与今天并无二致:不断试错、不断叠加,像呼吸一样自然。

所谓 AGI 之路,从来没有确定答案。不同的人在不同的方向上滋生出真正的技术信仰,持续探索,才有可能最终汇聚成一条路。

9 月 20 日,任少卿在个人主页新增了一个新头衔:中国科学技术大学讲席教授。他将在母校搭建人工智能实验室,致力于 “中长期通用人工智能的研究”。同时,蔚来的工作不变,继续负责智能驾驶。

“我们就是 AI 公司。”

在一家车企里说这句话,像是在开玩笑。但对任少卿来说,可能这就是答案。

一条更难、但真正通向 AGI 的道路——世界模型

晚点:这好像是你这几年第一次出来接受专访。

任少卿:之前没怎么讲,大家不知道我们在干什么。现在觉得可以讲讲了。

晚点:这两年,“端到端” 是一个经常被车企提到的词,但在其他 AI 领域却很少听说,蔚来也几乎不提这个词,为什么?

任少卿:端到端是智能驾驶历史阶段的产物。早期算力不足、神经网络不成熟,无法把驾驶问题一次性解决,只能把任务拆解成若干小模块——比如感知、预测、决策,再分别训练和拼接。过去十年神经网络快速发展,具备把这些碎片重新拼接的能力,于是出现了端到端的说法。

在语言、图像等其他 AI 应用,训练神经网络大多数时候都是一个整体,几乎没人说端到端,端到端是智能驾驶领域特有的历史语境。所以我觉得它不需要被特别强调。

回到大 AI 语境下,近五年真正的突破其实是大语言模型——它让 AI 基于语言有了 “概念认知” 的能力。

晚点: 大家都在用的 ChatGPT、DeepSeek,背后就是 LLM(大语言模型),语言模型的进步为什么这么关键?以及为什么光有语言模型,自动驾驶还是没办法完全落地?

任少卿:语言模型的突破在于,它把语言对应的概念和逻辑关系建模了出来。比如 “小狗” 或 “汽车”,在模型中是一个清晰的概念,模型能基于这些概念做理解和生成,这是过去 AI 没有的。

但语言是低带宽的,只能描述有限信息。比如,一张交通照片,你很容易用视觉看到 “有几辆车、什么状态”,但要用文字完整描述却极其复杂。更不用说动态场景:匝道口拥堵、车辆绕行、驾驶者的表情和意图。

所以,语言模型解决的是 “概念认知”,但在 “时空认知”——真实世界的四维时空(空间 + 时间)建模上仍有明显短板。比如复杂的交通场景、物理规律。

自动驾驶需要的恰恰就是 “时空认知”,这个空白,正是世界模型要去补的。世界模型的目标是建立基于视频/图像的 “时空认知”,补齐语言模型的短板。

晚点:你怎么定义 “世界模型”,它和语言模型是替代关系还是并行关系?

任少卿:蔚来是第一个在国内提出世界模型这个概念的。

我认为世界模型包含两个层面:

物理规律的内建:比如重力、惯性、速度变化,这些规律必须在模型内部形成;

时空操作能力:能理解和预测物体在三维空间 + 时间维度的运动,比如车辆绕行、机器人搬运。

语言模型和世界模型是并行的:前者是 “认知语言和概念”,后者是 “认知时空和规律”。

你可以把它想象成,语言模型解决 “我们懂不懂人类所创造的概念”,世界模型解决 “我们能不能在这个物理世界正确地运动和生存”。两者最终融合,才能形成真正的通用人工智能(AGI)。

晚点:智能驾驶行业还有一个词很火——VLA(Vision Language Action, 视觉-语言-动作),行业里有人认为 VLA 是世界模型的核心,也有说世界模型是用来给 VLA 做仿真评测的——观点几乎相反。你的理解是怎样的?

任少卿:这个我觉得要分开讲。VLA 本质还是语言模型的模态扩展。

- LLM(Large Language Model)只包含语言

- VLM(Vision Language Model)加了视觉

- VLA(Vision Language Action)再加上了动作

这些扩展虽然加入了新模态,但 “根” 依然在语言模型上。它像是在原有的语言体系上不断 “加模态”。

但世界模型不是 “语言加法”,而是要建立一套高带宽的认知系统。因为语言通道的带宽太低了。人类如果没有眼睛,只靠嘴和耳朵交流,效率会有多低?眼睛带来的视觉带宽就大得多。

晚点:你说世界模型要建立一个比语言模型(包括 VLA)更高带宽的时空认知能力。什么是 “高带宽”,能不能给我们一个更直观的比喻?

任少卿:可以用脑机接口来类比。人类现在的交流方式——嘴和耳朵——是低带宽的,只能输出有限信息。眼睛虽然能接收大量信息,但没法把画面直接 “投送” 出去。

如果有脑机接口,人就能直接输出图像,交流效率会极大提升。世界模型的意义类似:它要在 AI 里建立一个高带宽的认知通路,用图像直接交互,不依赖低带宽的语言。

晚点:听起来搞这样的模型就需要很多钱,更多训练资源和算力投入,以及更长的时间。

任少卿:是的,语言模型的训练是什么?在大量文本里预测下一个词。世界模型要学的是视频、画面,不是词。

晚点:但我理解 VLA 的训练里也包括大量视频和图片片段吧?

任少卿:对,但它是 “外挂” 的。

现在大部分 VLA、VLM 的做法,是先有一个语言模型基座,然后在一些图像数据上训练一个插件,把视觉转成语言,再输入到语言模型里。它的 “根” 还是语言,只是头上插了个视觉转换器。

这就是差别。世界模型要直接在视频端建立能力,而不是先转成语言。

晚点:特斯拉搭的是世界模型吗?理想和小鹏所说的基座模型,是哪一种?

任少卿:特斯拉我不太确定。理想和小鹏的 VLA 是以语言模型为训练底座。

晚点:既然世界模型更有效率,那语言在自动驾驶里还有必要吗? **就提出了 WA(World Action, 世界行为模型),并强调不需要 L(语言)。

任少卿:本质上**做的是世界模型,只是强调点不同。我们去年七月份之前就提过世界模型这个概念。

VLA、WA 这些名字,更多是表述方式的差别。关键还是要看它是否真正建立了时空认知能力,而不仅仅是在语言模型上做加法。

我认为语言仍然是很重要的,它有三大价值:

- 海量数据:语言模型吸收了海量互联网案例(尤其是 “彩色案例”,即有代表性和复杂性的场景)。这些数据对自动驾驶训练非常有帮助。

- 推理能力:通过链式推理(CoT, Chain of Thought),语言模型能带来一定的逻辑推理,弥补世界模型目前还未建立的细粒度推理。

- 人机交互:用户需要能像跟司机沟通一样,直接告诉车 “开进小区,左转,在楼下停”。这需要自然语言接口,而不仅仅是导航按钮或固定选项。

晚点:你提到 L(语言)在智驾里的一个重要作用——人机交互。但目前看,交互还很有限。这个问题怎么解决?

任少卿:这点非常关键。现在的智驾系统,你和它的交互都还是有限集的。它会给你一个列表——三条也好,五条、八条也好——你只能说这几条指令,它才会响应。除此之外的,它一概不管。但我们日常和司机交流不是这样的。你不会跟司机说话,他回一句:“不好意思,我只接受 123456 条命令”。

我们的最终目标,是通过 Open-set(开放集指令交互) 智能引擎实现真正的开放式交互。所谓 Open-set,就是把 L(语言)和 A(动作)彻底变成开放的:用户不再局限于输入有限的指令集,而是能够随意表达,系统也都能正确理解并执行。

从有限集到无限集——这才是语言加进去的终极意义。只是这一步我们还没做到。

晚点:现在做到哪一步了?

任少卿:还是有限集。给你一个列表,1 到 30,你可以说这些,组合一下。但除此之外就不行了。

所以目前 L(语言)在 VLA 里的最大作用,一个是用互联网数据,一个是做一些链式推理,但更重要的还是未来要做到开放式交互。我们会在后续版本里推出 Open-set(开放集指令交互),今年下半年推一个版本,年底的版本里就会有。

晚点:年底是全量推吗?

任少卿:我们有多个平台,会在今年年底到明年 Q1,一个一个推。2025 年 5 月我们在地库里找出口首发了:你跟它说 “帮我开出车库”、“开到某栋楼”,它就能执行。这在国内是第一个量产的语言交互功能。今年又加了很多功能,像紧急情况下靠边停车,AES 主动安全,倒车辅助等等,很多都是业内首发。

表面看是一个个新功能上线,背后是一整套体系支撑。说实话,冰山下还有很多技术我们已经在做,只是没发布。

晚点:你怎么看待各个车企之间智驾能力的差异?怎么判断自己和其他车企的真实进展?

任少卿:判断起来也不复杂,你看一个架构,它的上限在哪里;再看实际跑出来的结果,离上限还有多少差距。

我们从 Banyan 3.2.0 版本开始换到了世界模型的架构(今年 5 月蔚来推送了世界模型 NWM 的 OTA 更新)。大家都在讨论的 VLA,我们实际是在世界模型里实现了它,即在世界模型(视频驱动的时空认知模型)里引入语言模态,用来补充数据、推理和交互能力,而不只是做语音助手——这个产品形态我们也是国内第一家推的。

晚点:如果你们年底能推出 Open-set(开放集指令交互),是否意味着领先所有厂商?

任少卿:我觉得是。每家公司都像 F1 赛车换胎,要考虑现有架构还有多少空间能挖,定策略看什么时候换。

年底我们会发布 2.0 的迭代版本。从架构看,我们走得比较靠前。关键在于,怎么把新架构里能挖的果子尽快挖出来。每一代都是曲折上升,有时候要丢掉旧的东西,再重新实现,然后逐步把 60%、80% 的潜力释放出来。

晚点:我听起来,你们的路线其实很激进,没有延续已有方案,而是选择直接切世界模型,走一条高算力、多传感器、全新架构的路。

任少卿:在当时那个时间点,确实挺激进的。

1. 我们没有城区和高速各用一套方案,而是直接把它们统一到一套架构里,原来的系统几乎推倒重写。这样做开发量特别大,风险高,但长远来看会更干净,也更有扩展性。

2. 直接上 4 颗 Orin + 激光雷达,这种大算力 + 多传感器的配置,在行业里是非常超前、成本也高。友商可能低配先跑,我们是硬件一步到位,等于押注未来几年算力快速迭代。

3. 节奏上激进,2022 年 3 月在国内量产,8 月做了欧洲量产,跨两个大洲同时推进,对研发、交付、供应链都是极限压力。

但回头看,对用户来说不算坏事。比如特斯拉 HW5 芯片还没发,HW6 芯片就快出来了。算力在快速暴涨。

2022 年 3 月拿到车的用户,现在已经三年半了,再加上 7 年换车周期或更长,最少还剩三年半。那时候算力会到什么程度?以 4 颗 Orin 为例,如果当年买的车配了它,现在依然算是一个好选择,至少能保持中档水准。对用户来说,在这样一个使用周期里,它还是有竞争力的。

晚点:但这也导致了你们的进展有段时间是慢的。

任少卿:对。但有些看起来快的,未来也可能会慢下来。

晚点:不过,快慢重要,节奏也很重要。

任少卿:这不只是蔚来一个公司的节奏,是整个技术演进的趋势。

三年前,智驾、语言模型、机器人还是分开。近两年技术快速合流,大家的基建也比过去强太多了。以前做一件新事要几十个人,现在小规模团队就能搞定。

新的想法和技术点子层出不穷,不管是我们做还是别人做,行业一定会有人去尝试。

我们做很多事情,其实不是为了跟别人赛跑,而是希望能探索一些新的东西。这也是为什么早期看上去我们的进展不如友商快。但我们做得更多、选了更科学的路径,因为我认为这是一条真正可以通向未来的路,即便过程中我们要忍受一段时间的不被理解。

业内到现在也没有完全接受强化学习的重要性

晚点:你说你们是国内最早提出世界模型的,那国外呢?

任少卿:国外其实 SORA (OpenAI 的视频生成模型)出来的时候,大家就觉得它是个 “世界模型”。为什么当时大家那么震惊?就是突然发现它好像有了这种能力的苗头。

晚点:你定义的世界模型是以视频为底座,核心是 “时空认知”,所以它需要大量视频数据。这些视频数据从哪来?

任少卿:游戏是一个很重要的训练数据来源。比如腾讯最近推了一个版本,就是拿游戏来训的。在游戏里我按一下 “往前”“左转”“跳起来”,游戏引擎会自然渲染下一帧变成什么样。模型就能学到:前面是这样,我做了这个动作,后面变成那样。把这个逻辑迁移到真实世界,就是 “我在这个世界里运动会发生什么”。

第二类是真实数据。摄像头、激光雷达、毫米波雷达,这些数据量最大的,就是车厂。比如一段视频,中间司机踩了刹车,那前后场景的变化就是一个样本。久而久之,模型就学会了:如果我现在急刹,接下来会发生什么;如果我变道,会发生什么。这就是对时空认知的学习。

晚点:理想的智驾负责人曾说,他们从 80 万车主中,筛选 3% 老司机的驾驶数据来训,从而让模型做到和老司机一样的驾驶体验。你们也是这样做的么?

任少卿:其实我们不是。这是个很有意思的话题,你先回答我,到底我们需不需要车撞了的数据?

晚点:当然需要了。

任少卿:为什么呢?如果是专家数据就不会有这东西,因为专家开的都很标准。

晚点:不一定,很多老司机开车就非常激进。所以如果用海量用户数据训练,和用专家数据训练,效果会有什么差别?

任少卿:那我们先要明确自己要什么,最基础的是两块:语言模型带来的是 “概念认知”,世界模型带来的是 “时空认知”。把这两块拼在一起,最后才会走向 AGI。

基于这个框架,数据的选择就分成两种:

- 专家数据,干净,质量高,但量小、贵。比如找 300 个老司机开,采得很标准,但你没法找 3 万个。

- 量产数据,量大、成本低,分布广,什么情况都有——开得很标准的、有点冒失的,甚至有事故的。这样模型才能学会 “什么情况下会出错”。

但专家数据的弊端是缺少 corner case(极端/边界情况),不标准的情况都被过滤掉了。但真实世界恰恰充满这些边界情况。量产数据虽然 “脏”,但通过强化学习去 “洗”,反而能让模型学到更多、更复杂的东西。

晚点:当时很多厂商从规则往模型切的时候,用户会觉得,使用智驾的体验却变得更差了。我之前以为是模型 “学老司机学坏了”。你怎么解释这个 “倒退” 现象?

任少卿:我们发现一个特别有意思的例子,在小路上的驾驶场景。智驾车在小路上很容易遇到边界情况:车距很近,你得减速,还得打方向。如果是用专家数据,或者专家数据加一堆规则训出来的,这个场景就不容易做到丝滑。经常会一出边界,就切到兜底规则,车就 “一顿一顿” 的,体验很差。

我们在今年 5 月份推的版本,几乎没这个问题。因为我们用了大量的真实数据,里面既有非常标准、安心的驾驶,也有离其他车很近的情况。加上强化学习训练之后,整个系统在边界场景下也能连贯,不容易掉到兜底逻辑里。

晚点:所以这里有一个核心,就是 “强化学习”。我记得当时训语言模型的时候大家也遇到过类似问题:干净数据 vs 大量脏数据。

任少卿:以前的小数据集,比如李飞飞老师 2010 年搞的 ImageNet,100 万张精标图片,花了很多时间去标,质量很高,所以可以用模仿学习——老师做什么,我照抄就行。

大语言模型不一样,它直接把整个互联网的数据灌进去。这些数据洗不干净,里面有很多乱七八糟的、不合适的内容。没办法,量太大了。怎么办?在 GPT-3.5 之前大家是 “加规则”——不许输出这些词。

但后来就有了强化学习,它能把 “好的分布往前排,坏的往后放”,某种程度上相当于后端洗数据。智驾也一样:专家数据干净但量少,量产数据量大但脏,需要强化学习去洗。

晚点:在 AI 发展中,行业经历过迷茫期。比如当 Scaling law 的边际收益下降时,很多人觉得光靠堆算力走不下去了。直到 OpenAI 的 o1 模型出来,用强化学习把推理链条拉长,证明还有新路径。后来 DeepSeek 又通过 R1 系列走得更彻底,把谜题解开了。你怎么看这个演进?你是怎么意识到强化学习能解决智驾上的问题?

任少卿:我觉得整个行业到现在都还没有完全接受强化学习的重要性。我们相对比较早意识到,一方面当然是参考了语言模型的进展,另一方面,我们自己一直在做实验,所以比较早就看到两个关键作用。

它能 “洗数据”。模型的输出本身是一个分布,强化学习能把好的分布往前排,把差的往后压,相当于做了一次后端清洗。我们去年底的实验里就已经验证过这一点。

能延长 “上下文”。模仿学习像老师手把手教,5 秒钟、100 个词还行,但如果拉到 30 秒、10 万个词,就崩了。强化学习能把这个过程撑起来,让模型学会更长链条的推理。语言模型里就是把上下文从 1K 拉到 100K、甚至 1M;智驾里就是让车不再是个 “5 秒记忆的金鱼”,而是能处理 30 秒、60 秒连续过程的智能体。

OpenAI 的 o1 更多是 “让大家看到”,但我们在内部实验里,其实早期也看出来了。

晚点:现在大模型公司都接受了 “强化学习” 这条路,智驾行业是不是也一样?

任少卿:说实话,智驾行业现在做的不多。我们理解的那两个关键作用,国内真正用到量产的还很少。

这里要想明白一个问题:一个智能体在开车时到底需要什么能力?我把它分成两类:

“手把手” 的能力,5 秒、10 秒以内的短任务,看一个状态就知道要怎么操作,这个端到端模型大致能解决。

“长时序” 的能力,超过 10 秒、甚至 1 分钟、10 分钟,系统该怎么做?

过去这类长时序问题,几乎全靠代码搞定。两个来源:一个是地图,告诉你一条路一个月前修过、5 分钟前前方堵车了;另一个是 if/else 的规则库,比如遇到某场景该怎么办。它们确实能管用,但系统始终就是个 “5 秒记忆的金鱼”。

未来一定要靠强化学习,因为纯模仿学习没法学出这么长的规划。o1 就是例子,它在语言端激发了长时序规划的能力,很多过去做不到的,现在能做了。但语言有边界,很多东西描述不出来。回到智驾和机器人领域,就需要建立基于视频的长时序规划能力。

我们现在的方向也是这样——在现有模型上叠加强化学习,去把长时序的能力真正做出来。年底的新版本,应该会有一个比较明显的进展。

晚点:其他车厂或者供应商也会逐步转向强化学习吗?

任少卿:我觉得会转。现在大家可能都在研究,但是真正放到量产里,还没人大规模用。

从大模型的角度看,语言模型已经成了货架产品,大家都认可它。但世界模型一定是未来要做的事,这点没有悬念。

没有哪一家像我们这么变态:三层数据系统、三代首发平台、4×100 接力棒研发

晚点:你是 2020 年 8 月加入蔚来,当时蔚来自动驾驶是怎样的状态,你入职后接到的第一个任务是什么?

任少卿:第一代车已经基本开发完成,用的是国外的感知算法。2020 年我们决定要做全栈自研——从传感器到信息处理再到最终的决策输出,全部都自己来。当时还是分感知、规划、决策这些模块,但未来趋势就是要统一。

这也是我刚加入蔚来就意识到的事——再拆分已经不现实了。

晚点:当时团队多少人?

任少卿:就我一个人。

晚点:从零开始。

任少卿:NT1 团队是一代,NT2 是新一代,我能算是 NT2 智驾平台的第一个人吧。

我在 2020 年 8 月入职,2022 年 3 月就得量产,时间特别紧。当时硬件也没定,芯片没选,传感器也没完全确定,软件什么都没有。所以我到蔚来后,干的第一件事就是组建团队,到 2020 年底有了三五十个人,2021 年春节过后接近 100 人。雏形算是搭起来了,但光有人还不够,还要把标注系统、训练系统都建起来。

基本花了一年时间建团队、建数据系统,剩下八个月就开始冲量产。

晚点:为什么不集中精力做更少的事情,那么早建数据系统,有必要吗?

任少卿:还不止建了一个数据系统,我们建了三个层层递进的数据系统。

我们当时有个认知和行业很不一样。2020 年以前,大家普遍觉得数据没成本,采到了就拷一份。但我们觉得不是,数据只有经过自己模型筛出来的才有用。而模型筛选需要算力,算力是高成本的资源,所以我们那时的认知是 “数据约等于算力”。基于这个,我们建了三套数据系统。

第一套是 DLB (Data Loop Back 数据闭环系统),就是通过代码和模型自动筛选数据,形成有用数据进入训练/标注流程。

第二套是伴生系统,相当于车上有两套系统,一套跑用户功能,一套跑测试功能,就像互联网的 AB Test,把切流量的能力引入到车端。这样我们在主动安全上的迭代速度就比同行快很多,因为主动安全对误刹的要求极高,靠车队测试根本不现实,必须靠这种规模化的系统切流量去验证。

第三套是 RAMS(Risk Assessment and Management System 风险评估控制系统),它用来解决量产车每天上百万次接管怎么自动化分析的问题,做到每天消化几百万、上千万次接管数据。

从数据系统角度来说,我们现在的数据系统覆盖国内外车厂及方案供应商,应该是最顶尖之一。

晚点:三套系统花了多久搭建?一开始就做好了顶层设计吗,还是中间陆陆续续摸索出来的?

任少卿:2020 年我们想好了前两套——第一套花了大概一年多时间,第二套我们在 2022 年量产前就完成了,量产后就开始切主动安全。第三套是大概一年之后才想明白要建的。

晚点:从 2023 年底特斯拉 FSD V12 推送,到 2024 年一整年,智能驾驶从 “规则时代” 进入 “端到端时代”。你如何评估蔚来在技术切换关键点时的表现?

任少卿:我们也是逐步切换的,一开始还是需要规则兜底,到今天其实也还不是百分百模型。

题图来源:百度百科

免责声明:上述内容仅代表发帖人个人观点,不构成本平台的任何投资建议。

- 小狗摩天轮·2025-10-10能否分享一下那三套系统的具体优势?如何提升智能驾驶效果?点赞举报